[日本語まとめ] Can Autonomous Vehicles Identify, Recover From, and Adapt to Distribution Shifts?

Angelos Filos, Panagiotis Tigas, Rowan McAllister, Nicholas Rhinehart, Sergey Levine, Yarin Gal

- In International Conference on Machine Learning (ICML 2020)

- airxiv 2 Sep 2020

- site

- blog

- github openai gymのような感じで使える

- 日本語解説

どんなもの?

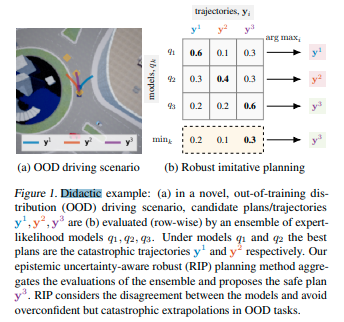

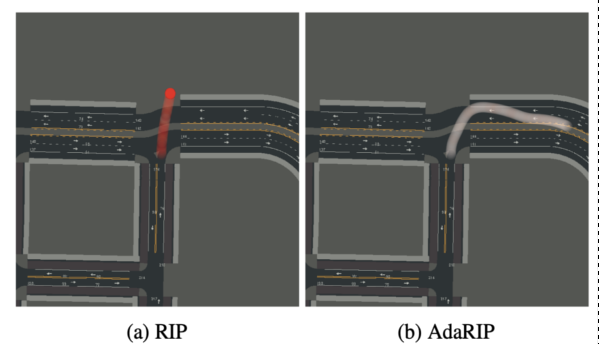

認識論的不確実性(epistemic uncertainty)(補足)を考慮した自動運転のための安全な経路計画(RIP=Robust Imitative Planning)を提案する。RIPはテスト時に起きる分布シフトに対応するため、複数のエキスパート軌跡を模倣する確率モデルを使い(Deep Ensembles)、それらの出力を集約し経路を計画する。これにより、いくつかの訓練データ分布外(Out-of-training-distribution, OOD)シナリオに対して、分布シフトを検出し、単一モデルが引き起こす十分な情報に基づいていない自信過剰で壊滅的な決定を防ぐこともしくは軽減することができる。

またAdaptive RIP(AdaRIP)を提案する。AdaRIPは分布シフトを検出することで、複数のモデルを使った場合でも不確実性が大きく安全な行動を提示できない場合に、エキスパートドライバーにフィードバックを問い合わせ、ドライバーが取った行動から自身のパラメータを更新するアルゴリズムである。AdaRIPはOODシナリオに対してエキスパートに操作を促すことによって安全性を損なうことなく現実世界で実行できる。

先行研究と比べてどこがすごい?何を解決したか?

Deep Imitative Models(arxiv, summary)(以下、DIM)の論文の結論に課題として述べられている認識論的不確実性について取り組んだ手法であり、OODシナリオを検出およびいくつかのOODシナリオに対して対応することができる。例えば訓練データに含まれないRoundaboutのシーンに対して走行することができる。これはDIMやLearning by Cheatingの方法ではできなかったことである。

手法は?

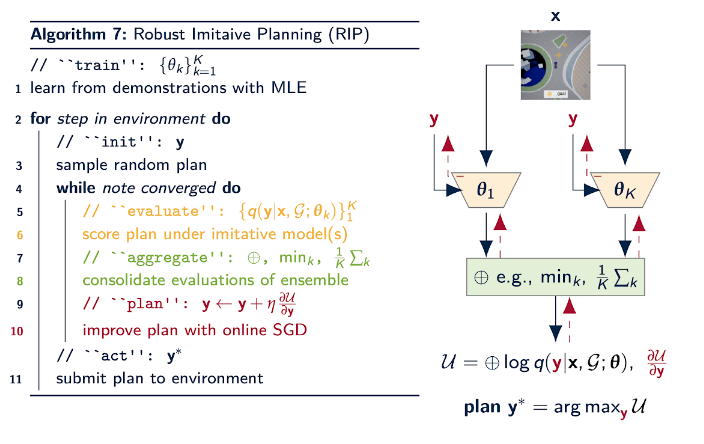

Robust Imitative Planning

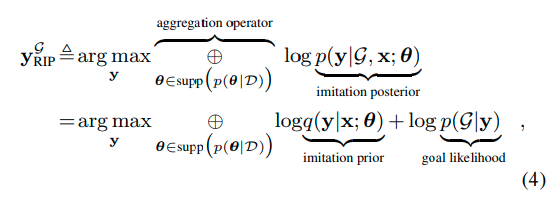

提案手法のRIPは複数のDIM\(p(\mathbf{y} \mid \mathcal{G}, \mathbf{x}; \mathbf{\theta})\)を用いて実行時に次式の最適化問題を解くことで、二次元の位置で構成される経路計画\(\mathbf{y}_{RIP}^{\mathcal{G}}\)を求める計画方法である。複数のDIMは例えばエキスパートのデータから分割されたデータおよびランダムな初期パラメータから模倣尤度を最大化するように別々に訓練されている。

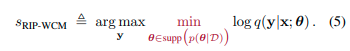

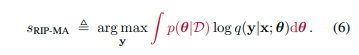

最適化問題に表れる\(\oplus\)はaggregation operatorである。集約する方法として最小の尤度をとるWorst Case Aggregation(5)と重み付き平均をおこなうModel Averaging Aggregation(6)を提案する。

この最適化問題は次のような最適化計算を行うことで解く。

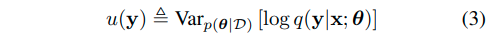

Adaptive RIP

複数のモデル尤度の分散は訓練分布内であれば低く分布外であれば大きくなることから、閾値を設けることで分布シフトを検出することができる。

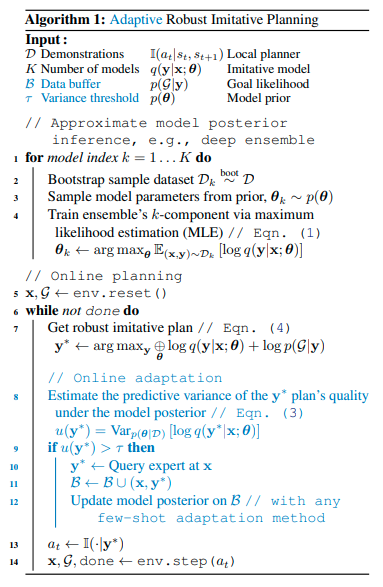

この検出方法を用いたAdaRIPは次のアルゴリズムである。

8~12行目に置いてRIPにより求めた経路計画の分散を計算し、その分散が一定以上であれば求めた計画の実行をやめ、エキスパートの助けを求める。そして得られたデータを使ってモデルを更新する。

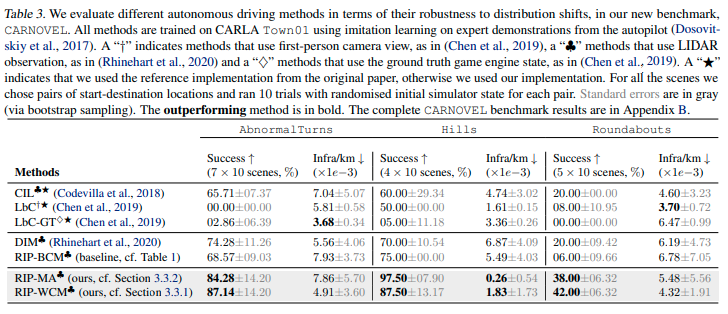

どうやって有効だと検証した?

OODの検出やリカバリに対する性能を示すためOODシナリオを含むデータセットCARNOVELをCARLAを用いて作成した。RIPおよび現在のstate-of-artの手法をこのデータセットおよびnuScenesで検証した。RIPの性能がその他の性能を上回っていることから、分布シフトから回復するための明示的なRIPのメカニズムが自動運転の性能を改善することを示している。

課題は?議論はある?

RIPは複数のモデルを使うので計算量が大きくリアルタイムで使うには無理がある。偶発的および認識論的不確実性を捉えたモデルを使ったリアルタイムプランニングは、決定論的な対応方法にまだ遅れをとっている。またRIPはOODシナリオに対して十分な対応をできない場合がある。

AdaRIPは、多くのオンライン方法と同様に、壊滅的な忘却とサンプルの非効率性が発生する。

次に読むべき論文は?

PILOT: Efficient Planning by Imitation Learning and Optimisation for Safe Autonomous Driving

Contingencies from Observations: Tractable Contingency Planning with Learned Behavior Models

ちょっとした補足

問題設定における仮定

この論文は以下の仮定を置いている

- x,yのエキスパートの経路および高次元の観測(LiDARなど)で構成されたデータセットにアクセスできる

- 2点間の位置と逆ダイナミクスを用いて、行動が決定されるものとする。

- 目的地に向かうまでのナビゲーション(右折、左折など)が得られるとする。

- ゴールや事故位置などの位置情報は完璧である。

RIP(Robust Imitative Planning)

ほぼ同じ著者で構成されるRobust Imitative Planning: Planning from Demonstrations Under Uncertaintyという論文をWeb上で見つけることができる。RIPのみが提案されている。

Panagiotis Tigas, Angelos Filos, Rowan McAllister, Nicholas Rhinehart, Sergey Levine, Yarin Gal, Robust Imitative Planning: Planning from Demonstrations Under UncertaintyMachine Learning for Autonomous Driving Workshop at the 33rd Conference on Neural Information Processing Systems (NeurIPS 2019), Vancouver, Canada. PDF

認識論的不確実性

認識論的不確実性とは知識または情報が不足していることに起因する不確実性である。知識や情報を蓄積することでこの不確実性を小さくすることができる。一方で偶然的不確実性とは、時間または空間的な変動、個体間に存在するばらつきなどから生じる不確実性である。この不確実性は小さくすることはできない。

認識論的不確実性に対して、ネットワークモデルはあまりにも脆弱である。訓練データ分布外のデータに対する推論は信用できるものではない。これに対して、Simple and Scalable Predictive Uncertainty Estimation using Deep Ensemblesは、Bayesian Networkに代わって複数のモデルを用いたモデルの不確実性を定量化する方法を提供する。Deep Ensemblesの他にDropout as a Bayesian Approximation: Representing Model Uncertainty in Deep Learningがある。

参考

- 緒方 裕光, リスク解析における不確実性, 日本リスク研究学会誌 19(2):3-9(2009)

- Deep EnsemblesでDeep Learningの不確かさを評価する

- 私たちが愛した3つのNIPS論文